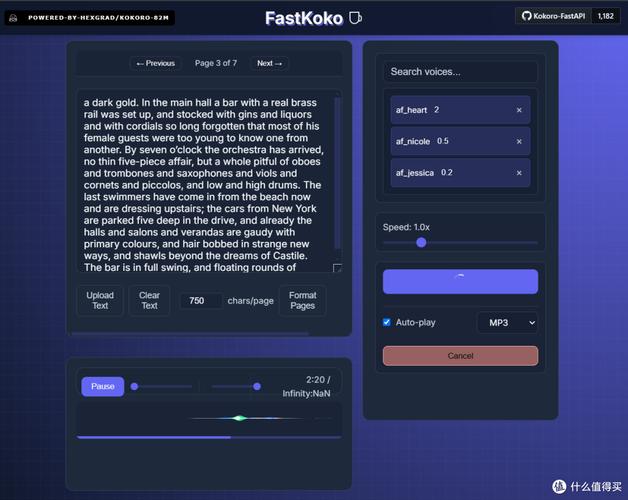

🚀 如何用 Kokoro TTS 实现低成本语音合成?手把手教你用 FastAPI 接口 + 队列处理构建高效方案

最近有不少朋友问我,有没有办法用更低的成本实现高质量语音合成。今天就来给大家分享一个超实用的方案 —— 结合 Kokoro TTS、FastAPI 接口和队列处理,既能保证语音质量,又能大幅降低成本。

🔍 为什么选择 Kokoro TTS?

先给大家介绍一下 Kokoro TTS。这个模型可不简单,虽然只有 8200 万参数,但语音合成效果能和大型模型媲美。它支持多语言,像英语、日语、韩语、中文这些主流语言都不在话下,甚至还能生成耳语等特殊风格的语音。而且它的成本极低,每百万字符的处理费用还不到 1 美元,在 A100 GPU 上训练 500 小时的成本也才 600 美元左右。更厉害的是,它能在浏览器中本地运行,用 WebGPU 加速,数据隐私有保障,延迟还低,特别适合实时交互场景。

🛠️ 搭建 FastAPI 接口

接下来咱们就一步步教大家搭建这个语音合成系统。首先得有个 FastAPI 接口,用来接收用户的文本请求并返回合成的语音。

第一步:安装依赖

要运行这个项目,需要先安装一些必要的库。打开终端,输入以下命令:

pip install fastapi uvicorn kokoro celery redis

这里面,fastapi是用来构建接口的框架,uvicorn是 ASGI 服务器,kokoro是语音合成模型,celery和redis则是用来处理队列任务的。

第二步:创建 FastAPI 应用

新建一个 Python 文件,比如叫main.py,然后写入以下代码:

from fastapi import FastAPI

from pydantic import BaseModel

import asyncio

from celery import Celery

app = FastAPI()

# 配置Celery

celery_app = Celery('tasks', broker='redis://localhost:6379/0', backend='redis://localhost:6379/0')

class TextRequest(BaseModel):

text: str

lang: str = 'en'

voice: str = 'default'

@app.post("/synthesize")

async def synthesize_text(request: TextRequest):

# 异步调用Celery任务

task = synthesize_task.delay(request.text, request.lang, request.voice)

return {"task_id": task.id}

@celery_app.task

def synthesize_task(text, lang, voice):

# 这里调用Kokoro TTS进行语音合成

# 具体实现需要根据Kokoro的API来编写

# 假设这里有一个函数generate_speech可以生成语音

audio = generate_speech(text, lang, voice)

return audio

这段代码创建了一个 FastAPI 应用,定义了一个接收文本请求的接口/synthesize,并使用 Celery 来异步处理语音合成任务。

📊 队列处理优化

为什么要用队列处理呢?因为语音合成可能比较耗时,如果同时有大量请求,直接处理很容易导致系统崩溃。队列就像是一个缓冲区,把任务按顺序排队处理,这样系统就能保持稳定。

第一步:启动 Celery Worker

在另一个终端中,输入以下命令启动 Celery Worker:

celery -A main.celery worker --loglevel=info

这样,Celery 就会开始监听 Redis 队列中的任务,并逐个处理。

第二步:设置任务优先级

如果有些任务比较紧急,我们可以给它们设置更高的优先级。在 Celery 的配置中,可以这样设置:

celery_app.conf.task_routes = {

'main.synthesize_task': {

'queue': 'tts_queue',

'priority':

}

}

这里把synthesize_task任务路由到名为tts_queue的队列,并设置优先级为 10。优先级越高,任务就会被越早处理。

🚦 成本优化策略

说了这么多,怎么才能降低成本呢?这里给大家分享几个实用的方法。

1. 合理选择硬件资源

Kokoro TTS 在 CPU 上就能运行,虽然速度可能不如 GPU,但成本更低。如果对实时性要求不高,可以优先使用 CPU。如果需要处理大量请求,可以考虑使用 GPU,但要注意按需扩展,避免资源浪费。

2. 利用异步处理和队列

通过 FastAPI 的异步接口和 Celery 队列,我们可以在高并发时把任务排队处理,避免服务器过载。这样就不需要为了应对突发流量而购买大量的服务器资源,降低了硬件成本。

3. 缓存高频请求

对于一些经常被请求的文本内容,可以把合成好的语音缓存起来。下次再收到相同的请求时,直接从缓存中读取,不需要重新合成。可以使用 Redis 来实现缓存,具体代码如下:

from fastapi import FastAPI

from pydantic import BaseModel

import asyncio

from celery import Celery

import redis

app = FastAPI()

cache = redis.Redis(host='localhost', port=, db=)

class TextRequest(BaseModel):

text: str

lang: str = 'en'

voice: str = 'default'

@app.post("/synthesize")

async def synthesize_text(request: TextRequest):

# 检查缓存

cache_key = f"{request.text}-{request.lang}-{request.voice}"

cached_audio = cache.get(cache_key)

if cached_audio:

return {"audio": cached_audio.decode()}

# 异步调用Celery任务

task = synthesize_task.delay(request.text, request.lang, request.voice)

return {"task_id": task.id}

@celery_app.task

def synthesize_task(text, lang, voice):

# 生成语音

audio = generate_speech(text, lang, voice)

# 缓存结果

cache_key = f"{text}-{lang}-{voice}"

cache.set(cache_key, audio, ex=) # 缓存1小时

return audio

🛠️ 错误处理和监控

在实际运行中,难免会遇到各种问题,所以错误处理和监控也很重要。

错误处理

Kokoro TTS 在处理文本时可能会遇到各种错误,比如文本过长、语音包不可用等。我们可以在 FastAPI 接口中捕获这些错误,并返回友好的提示信息。例如:

from fastapi import FastAPI, HTTPException

from pydantic import BaseModel

import asyncio

from celery import Celery

app = FastAPI()

class TextRequest(BaseModel):

text: str

lang: str = 'en'

voice: str = 'default'

@app.post("/synthesize")

async def synthesize_text(request: TextRequest):

try:

# 异步调用Celery任务

task = synthesize_task.delay(request.text, request.lang, request.voice)

return {"task_id": task.id}

except Exception as e:

raise HTTPException(status_code=, detail=str(e))

@celery_app.task

def synthesize_task(text, lang, voice):

try:

# 生成语音

audio = generate_speech(text, lang, voice)

return audio

except Exception as e:

# 记录错误日志

print(f"Error generating speech: {e}")

raise

监控

为了及时了解系统的运行状态,我们可以添加监控功能。可以使用 Prometheus 和 Grafana 来监控 FastAPI 接口和 Celery 队列的性能指标,比如请求处理时间、队列长度等。具体步骤如下:

- 安装 Prometheus 和 Grafana。

- 在 FastAPI 应用中添加 Prometheus 指标:

from fastapi import FastAPI

from prometheus_client import Counter, Histogram

app = FastAPI()

# 定义指标

REQUEST_COUNTER = Counter('tts_requests_total', 'Total number of TTS requests')

REQUEST_LATENCY = Histogram('tts_request_latency_seconds', 'Latency of TTS requests')

@app.post("/synthesize")

async def synthesize_text(request: TextRequest):

REQUEST_COUNTER.inc()

with REQUEST_LATENCY.time():

# 处理请求

pass

99

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

from fastapi import FastAPI

from prometheus_client import Counter, Histogram

app = FastAPI()

# 定义指标

REQUEST_COUNTER = Counter('tts_requests_total', 'Total number of TTS requests')

REQUEST_LATENCY = Histogram('tts_request_latency_seconds', 'Latency of TTS requests')

@app.post("/synthesize")

async def synthesize_text(request: TextRequest):

REQUEST_COUNTER.inc()

with REQUEST_LATENCY.time():

# 处理请求

pass

- 配置 Prometheus 抓取指标。

- 在 Grafana 中导入 Prometheus 数据源,并创建仪表盘。

🌟 总结

通过结合 Kokoro TTS、FastAPI 接口和队列处理,我们可以构建一个低成本、高性能的语音合成系统。Kokoro TTS 提供了高质量的语音合成,FastAPI 搭建了高效的接口,而队列处理和成本优化策略则保证了系统的稳定性和经济性。希望这篇文章能帮助大家快速上手,实现自己的语音合成项目。

该文章由

dudu123.com嘟嘟 ai 导航整理,嘟嘟 AI 导航汇集全网优质网址资源和最新优质 AI 工具